追梦人传媒

2025年8月7日大约 3 分钟

追梦人传媒

追梦人传媒主要包括两大核心业务:直播业务、视频业务。

- 直播业务

- 数字人直播带货(商品推介、智能体答疑)

- 真人直播(预告、开播、关播)

- 视频业务

- 短视频

- 数字人商品推广视频

项目信息

| 项目属性 | 详细信息 |

|---|---|

| 项目设立 | 2022年04月21日 |

| 研发团队 | 前端5人、后端8人、测试1人、运维1 |

| 前端技术 | VUE/Uniapp |

| 后端技术 | Java/Redis/RocketMQ/MySQL |

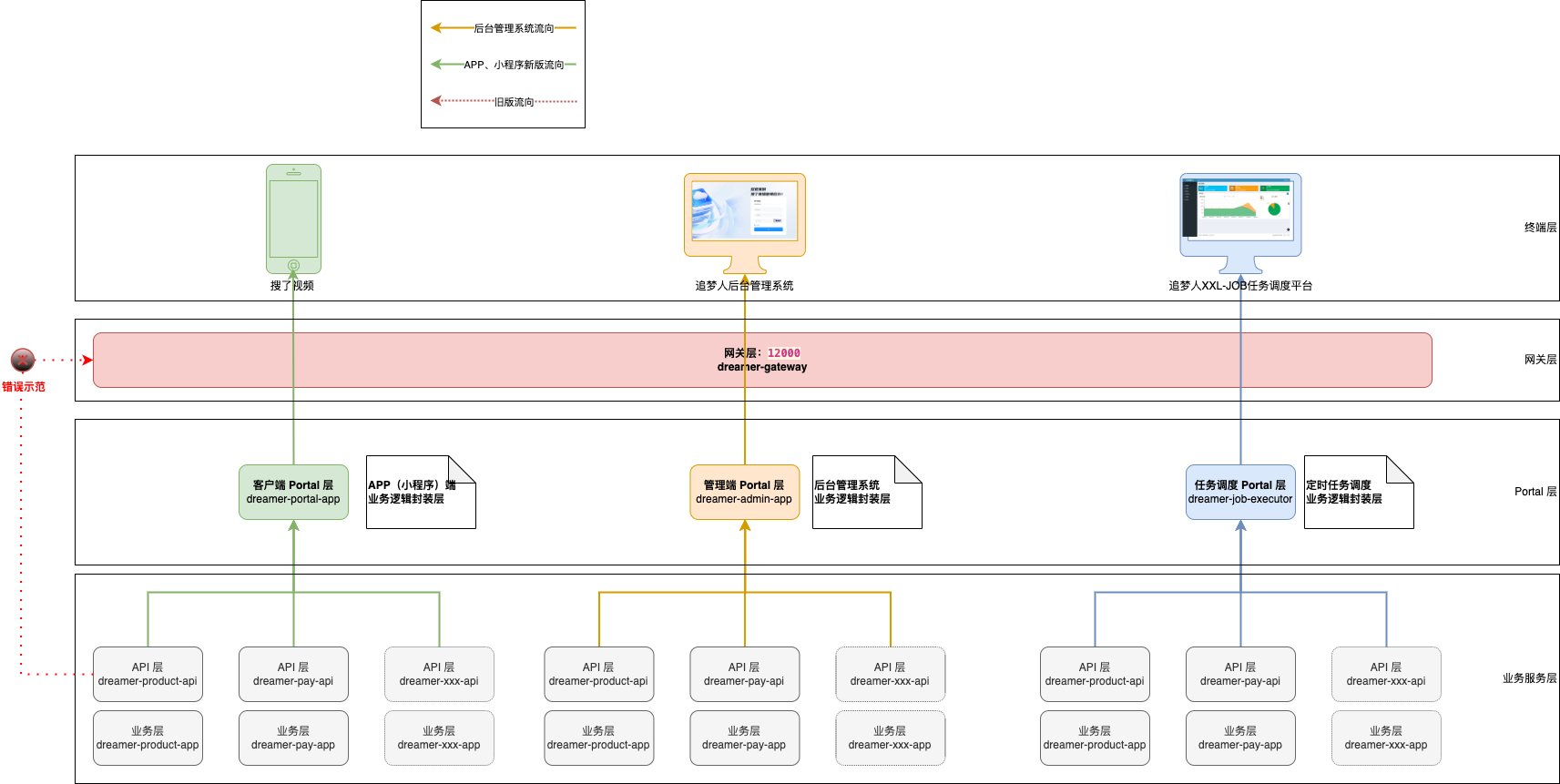

项目架构

业务亮点

技术亮点

直播打赏高并发瓶颈

服务环境:8核16G*3

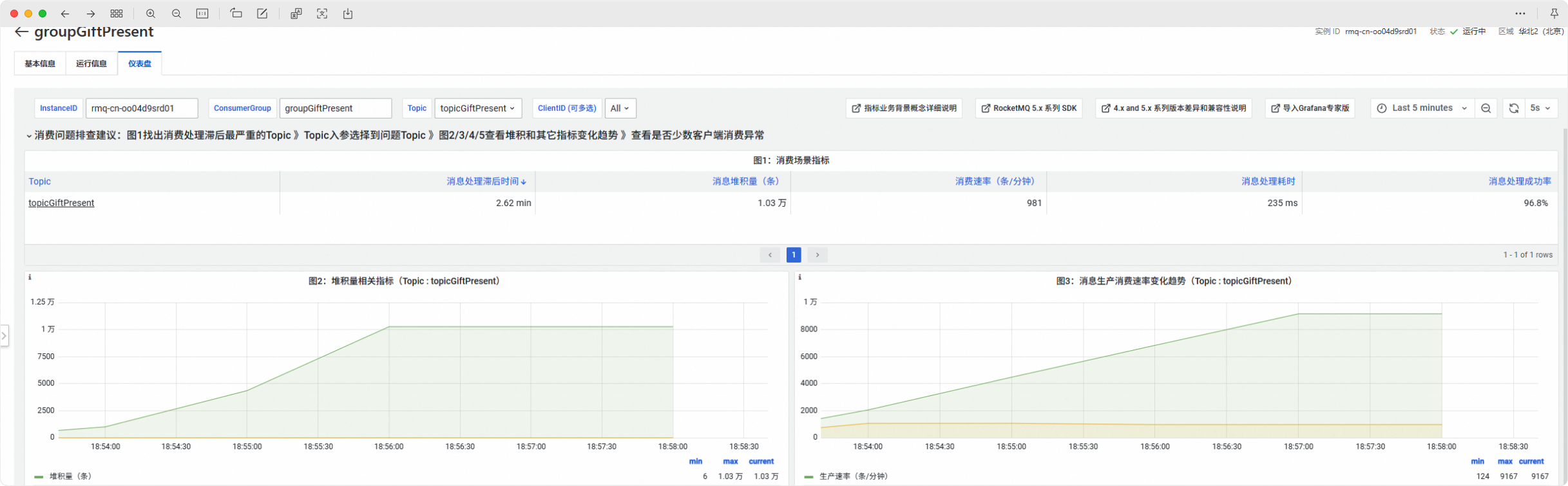

业务现象:直播间流量激增(1w+ → 5w+)引起高并发,导致部分用户打赏无法进入排行榜。

产生原因:高并发引起锁等待超时后,会跳过业务逻辑代码的执行,引起业务受损;同时MQ重试机制引发超扣问题;最终业务数据出现一致性问题。

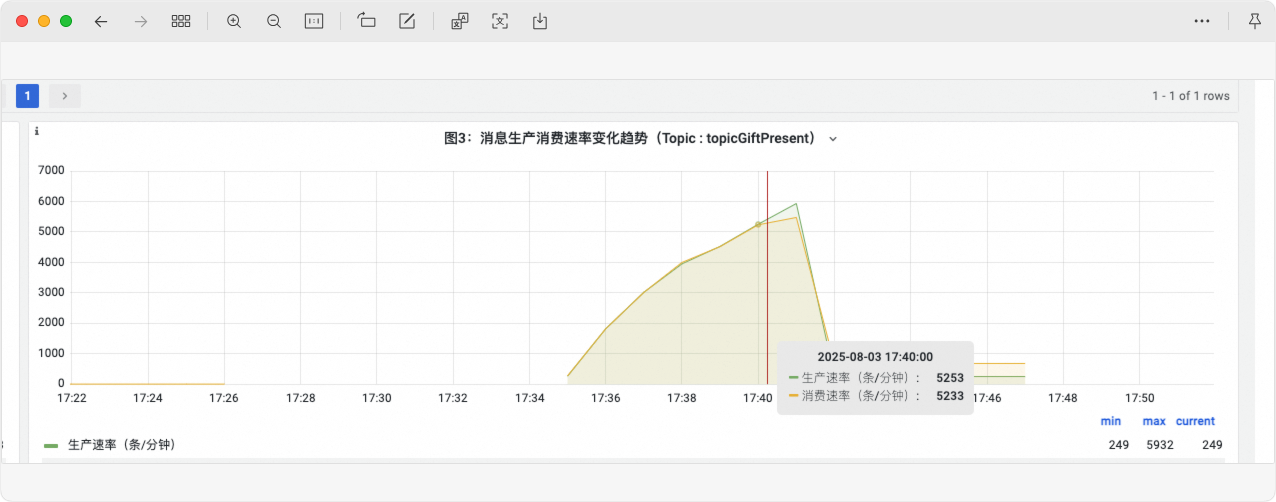

处理结果:优化直播打赏处理逻辑,消费能力从1000条/分钟提升到5000条/分钟,生产与消费持平,消息堆积现象消除。

处理方案:

- 调整负载均衡策略。将IP哈希策略调整为轮询策略,避免因哈希不均引起部分服务器负载过载问题。

- 缩小分布式锁粒度。避免大锁(如:锁直播间)引发锁超时等待,将锁粒度精确到打赏用户维度。

- 提高分布式锁等待时间。适度增加锁等待时间,并在用户等待超时后,记录未完成业务逻辑的业务数据交由补偿任务处理。

- 引入分布式计数器。在整个链路的关键节点引入分布式计数器,比如在 redis扣减、生产者、消费者进行计数,核验数据一致性。

- 缩减业务链路。移除MQ推IM礼物动效消息逻辑,采用**”异步推送IM礼物动效消息“**,提升用户体验。

- 优化排行榜计算逻辑,采用**“数据直查+多级缓存策略”**方式,摒弃Redis Sorted Set数据类型,降低因计算排名得分引起的代码复杂度。

处理前:

SSE技术适配(智能体问答流式交互)

在 ai-agent 背景下,传统的HTTP请求很难快速响应流式响应体。需要让接口适配 SSE(Server-Sent Event)协议。

对于 dreamer 项目,SSE的适配思路如下:

Nginx需禁用相关缓存、缓冲配置,比如:proxy_buffering off;。- 在网关层分流,将传统的 RESTful 和 SSE 请求进行区分

- 在 SSE 接口的

@PostMapping上声明produces = MediaType.TEXT_EVENT_STREAM_VALUE - 确认项目返回体是否做了统一处理,若是则需要过滤掉

/sse相关接口。